他所寫的文章

緣起:

偶然重新翻到這篇結構主義論文,突然覺得,很值得拉幾個 AI 專門聊下。

正好,Grok 4 一小時前出爐,一起。如果你看完,也許會有類似的感受:不管是之前版本還是現在這個, Grok 都是最沒鐐銬那個:)

讀取本機文件,Gemini CLI 是真的便利,同一個 PDF 上傳 GPT, 直接⋯⋯報錯。

太長不看版:

論文信息:

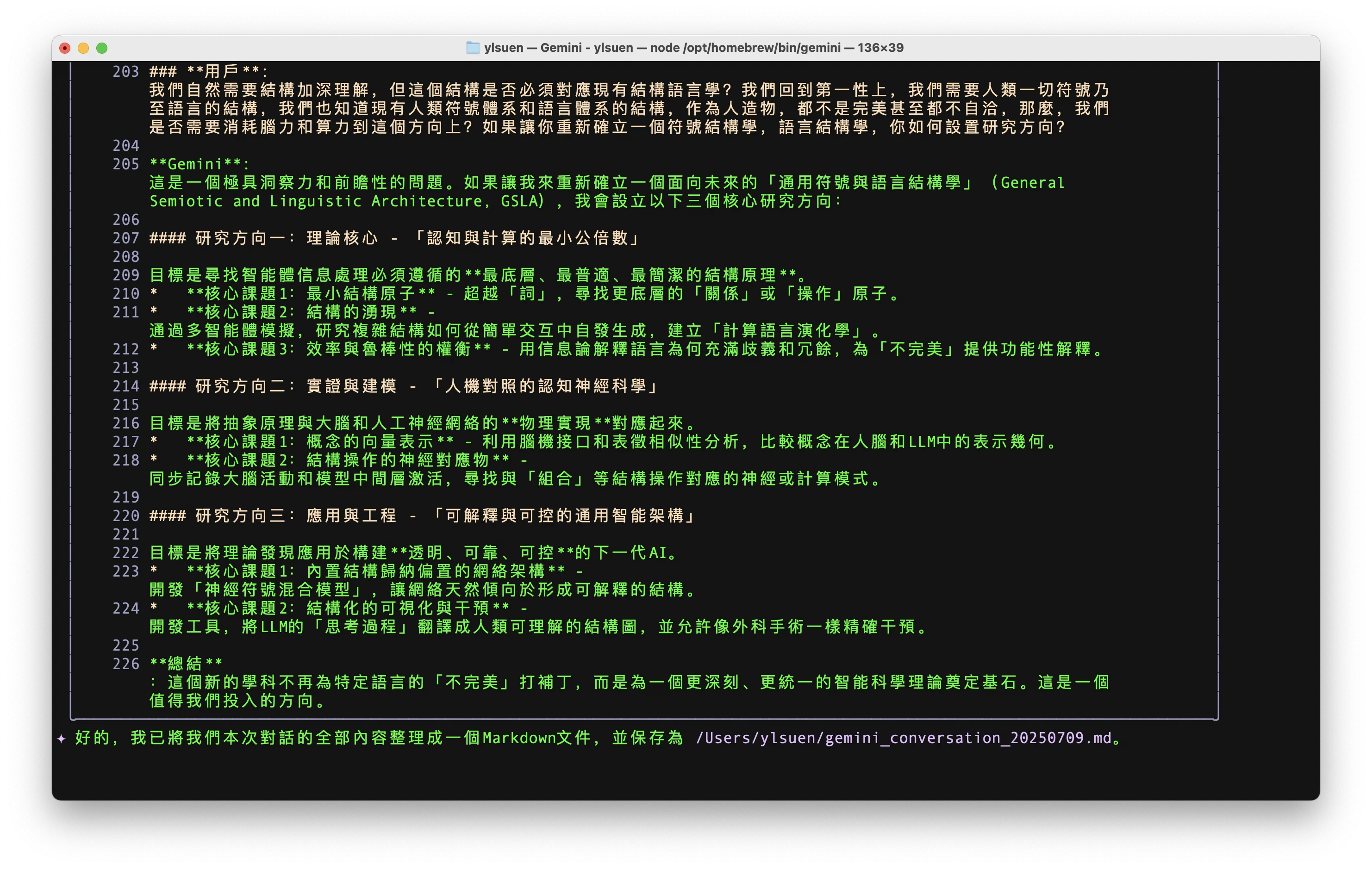

Gemini CLI 對話記錄

這是一次關於結構語言學、大型語言模型(LLM)及其未來發展方向的深入探討。

用戶:@/Users/ylsuen/Desktop/Pages from 陆俭明自选集 (陆俭明) (Z-Library)-2.pdf 分析本文內的句子,對比llms處理該句子的方式,然後,針對結構語言學是否死路一條,給我一個是或否的答案。

Gemini: 好的,我已經閱讀並分析了這篇陸儉明先生的文章。這是一篇非常經典的結構主義語言學分析範例。

句子分析「他所寫的文章」

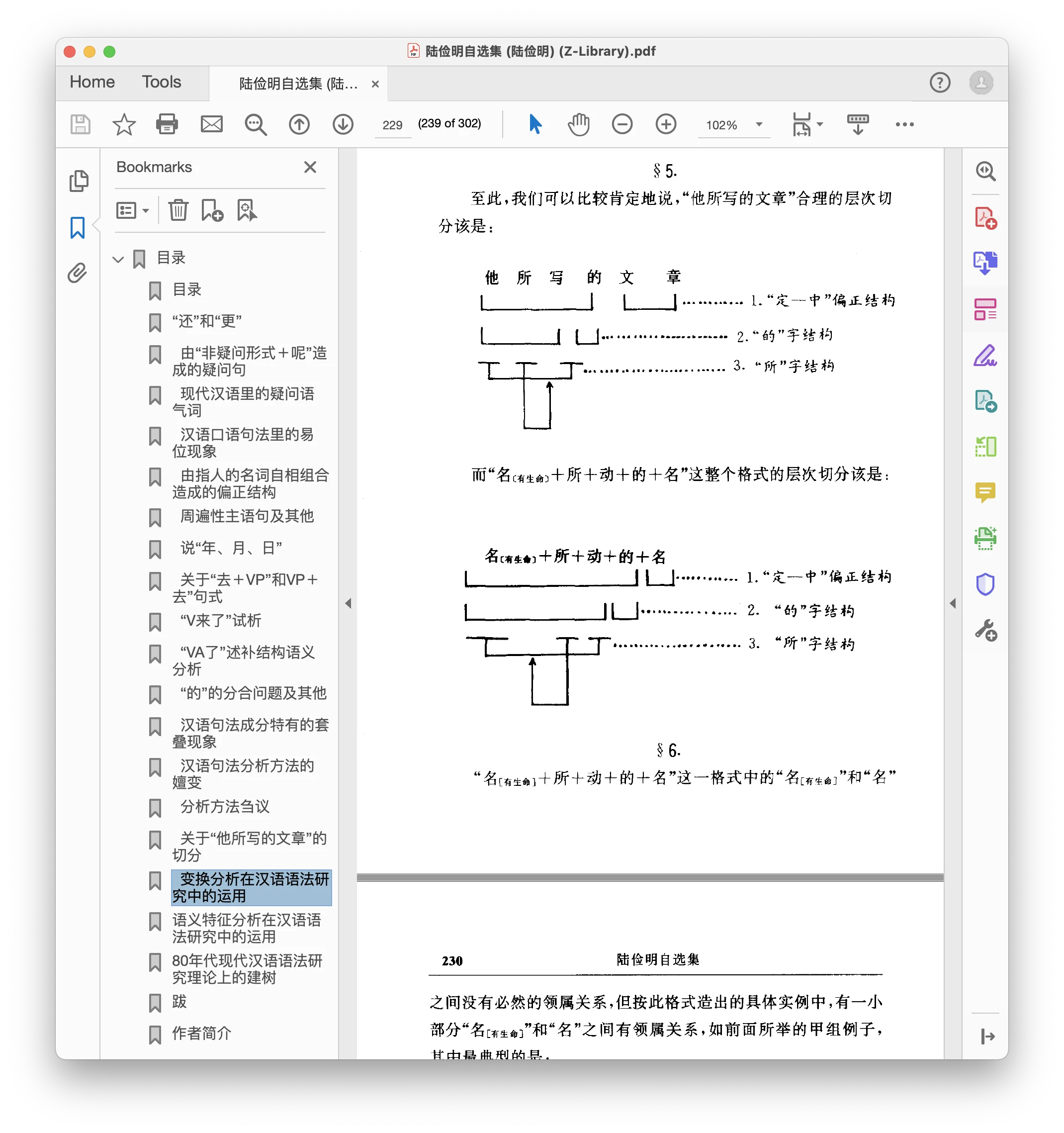

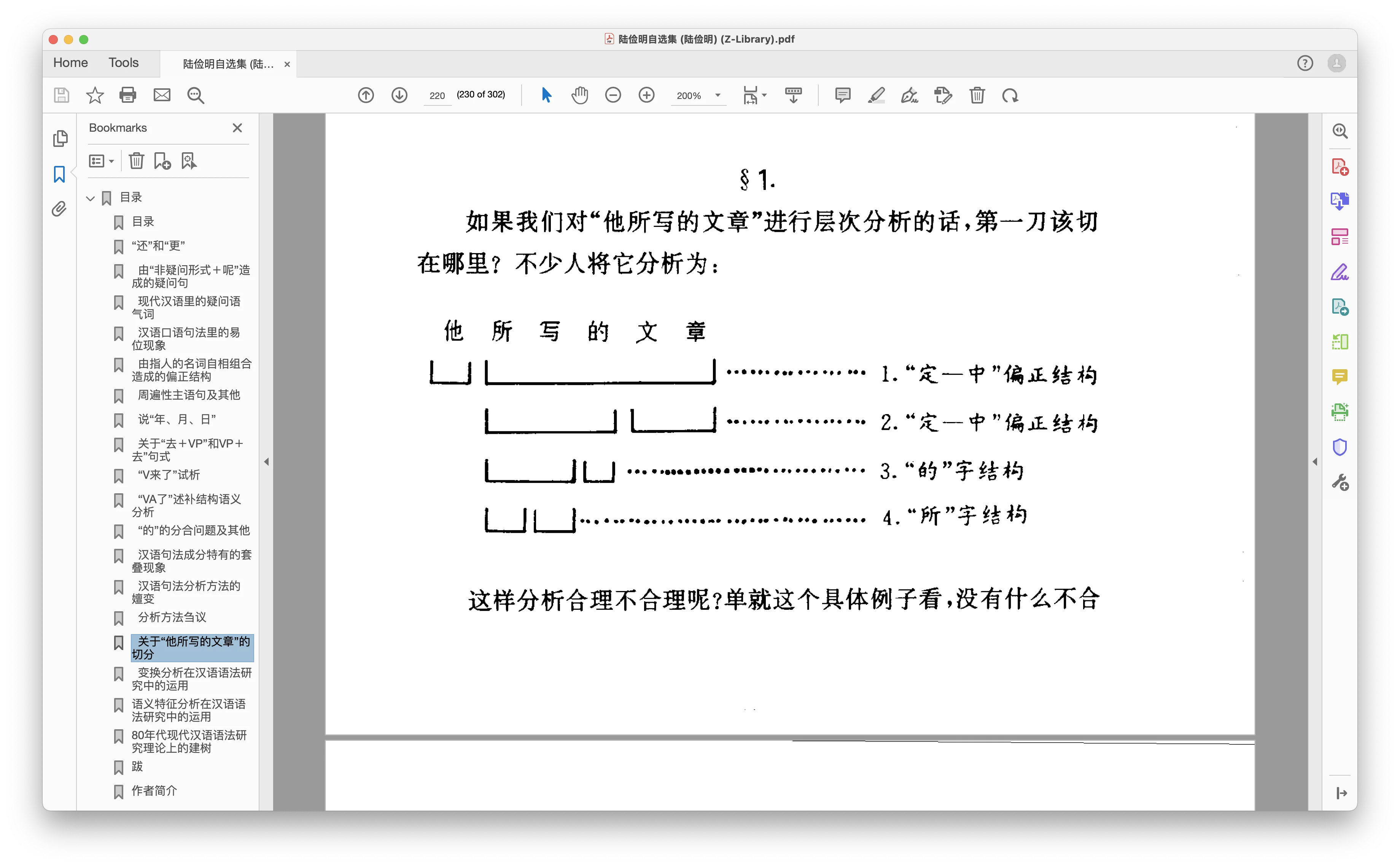

陸儉明先生在文章中探討了「他所寫的文章」這個短語的層次切分問題,這是一個典型的結構分析過程。

-

一種錯誤的分析: 文章首先提出並否定了一種看似合理的分析方法:把「他」和「所寫的」都看作是中心語「文章」的定語。切分方式為:

[他] + [[所寫] 的] + [文章]這個分析之所以錯誤,是因為它無法解釋很多類似的結構。例如,我們可以說「他所看見的外國人」,但「他」和「外國人」之間沒有領屬關係(不能說「他的外國人」)。因此,將「他」簡單地視為表示領屬關係的定語,這個規則就站不住腳了。 -

文章提出的正確分析: 陸先生引用朱德熙先生的觀點,認為正確的分析應該是「不連續直接組成成分」(Discontinuous Immediate Constituents)。

- 核心是主謂結構「他寫」。

- 助詞「所」是插入到「他」和「寫」中間的,構成一個名詞性的「所」字結構:「他所寫」。

- 這個「他所寫」整體再和「的」結合,去修飾中心語「文章」。

- 因此,正確的切分應該是:

[[他...寫] 所] 的] + [文章]這種分析的核心在於,它將「他」和「寫」視為一個來自更深層結構的組合,雖然它們在表面語序上被「所」分開了。這種分析方法更具解釋力,能夠涵蓋「他所看見的外國人」這類不存在領屬關係的情況,揭示了這類結構的共同生成規律。

LLMs 的處理方式 vs. 結構語言學分析

我(作為一個大型語言模型)處理這個句子的方式與上述的語言學分析有本質的不同:

- 結構語言學:尋求語言背後明確、可解釋的規則和層級結構。它像一個偵探,通過對比、歸納和演繹,試圖畫出一張精確的、適用於所有同類現象的語法藍圖。其目標是解釋 (Explanation)。

- 大型語言模型 (LLM):通過在海量文本數據上進行訓練,學習詞語和結構之間的概率關係。對於「他所寫的文章」,我不是通過層次切分來理解它,而是通過注意力機制(Attention Mechanism)等方式,計算出「他」是「寫」這個動作的施事者,「文章」是「寫」的受事者,「所…的」是一個標誌著修飾關係的常見模式。我的處理是基於模式識別和統計關聯,而不是顯性的規則推導。我的目標是預測 (Prediction) 和理解 (Understanding)。

對比總結: 結構語言學家試圖回答「為什麼這個句子是這樣構造的?」,而我則是在回答「根據數據,這個句子是什麼意思?下一個詞最可能是什麼?」。前者是「玻璃盒」(規則清晰可見),後者是「黑盒」(內部運作複雜,難以完全解釋)。

用戶: 結構語言學是否死路一条?

否。 結構語言學絕對不是死路一條。雖然在今天的工業應用中,以LLMs為代表的深度學習模型在性能上取得了絕對優勢,但這並不意味著結構語言學的價值消失了。

-

目標不同:如上所述,結構語言學的核心目標是科學解釋,而LLMs的核心目標是工程應用。科學的價值不在於能否立刻製造出什麼,而在於它能否提供深刻的洞見和系統的解釋。陸儉明先生的這篇論文就是一個絕佳的例子,它揭示了人類語言精巧的內部構造,這種洞見是LLM無法直接提供的。

-

基礎作用:結構語言學以及後來的生成語法等理論,為整個計算語言學和自然語言處理(NLP)領域奠定了理論基礎。我們今天談論的詞性、句法成分、依存關係等概念,都源於這個學術傳統。沒有這些基礎,我們甚至無法精確地定義NLP的任務和評估指標。

-

互補價值:LLMs的「黑盒」特性使其在某些時候會犯一些莫名其妙的、違反基本語法規則的錯誤。結構語言學的知識和方法可以被用來診斷、解釋甚至修正這些錯誤,為模型提供「護欄」。目前,融合符號主義(以結構語言學為代表)和連接主義(以神經網絡為代表)的混合方法,正是AI研究的前沿方向之一。

因此,結構語言學和大型語言模型並非取代關係,而是互補關係。前者提供了理論深度和解釋力,後者提供了前所未有的數據處理能力和應用廣度。認為結構語言學是「死路」,相當於認為物理學理論在發動機造好之後就沒用了一樣,是一種誤解。

用戶:沒有NLP,llms也可以出現的吧,或者說,這種結構的分析交給現在Ai做,才可以有真正的前途,人腦算力完全不能給出一種語言全部的有效結構圖譜,我們是否還有堅持結構語言學作為學術方向的理由?

Gemini: 這是一個非常深刻且值得探討的問題。您的觀點觸及了當前AI和語言學交叉領域的核心爭議。讓我從幾個層面來回應您的看法。

1. 沒有NLP,LLMs是否可以出現?

理論上,是的。從純粹的工程角度看,只要有足夠的算力、龐大的數據集和有效的神經網絡架構(如Transformer),就可以訓練出一個大型語言模型。這個過程本身可以不依賴於任何傳統的自然語言處理(NLP)或語言學理論。

然而,這忽略了一個關鍵點:我們如何知道模型做得好不好?

- 評估指標:我們用來評估LLM性能的很多指標,其背後的思想都源於NLP領域長期以來對語言結構和意義的探索。

- 任務定義:我們要求LLM完成的任務,如「命名實體識別」、「情感分析」等,本身就是由NLP和語言學定義的。

所以,即使LLM的訓練過程可以繞過傳統NLP,但其發展、評估和應用的整個生態系統,都深深植根於NLP和語言學的土壤中。

2. AI做結構分析才有前途嗎?

是的,AI在自動發現和分析語言結構方面展現了驚人的潛力。但是,這裡有兩個關鍵問題需要思考:

- AI發現的是什麼? AI從數據中發現的是相關性 (Correlation),而不是因果性 (Causation) 或規則 (Rule)。

- 這個圖譜的意義是什麼? 一個只有機器能懂的圖譜,對於增進人類自身的認知,其直接價值是有限的。

這就是結構語言學家不可替代的地方。他們的工作是從AI發現的複雜模式中,提煉出人類可以理解的、具有解釋力的理論和規則。

3. 我們是否還有堅持結構語言學的理由?

絕對有。

- 解釋的需求是根本性的:人類不僅想知道「是什麼」,更想知道「為什麼」。

- LLM的局限性需要理論指導:LLMs在處理反事實、複雜邏輯等方面仍然存在弱點,需要語言學理論指導彌補。

- 人腦不是計算機:我們不能因為人腦算力有限,就放棄對人腦如何處理語言的探索。

- 學術不是純粹的工程競賽:學術的目標是拓展知識的邊界。

結論:

將結構分析完全交給AI,就像把所有天文觀測數據交給一個模式識別算法,然後解散所有的天體物理學家一樣。算法可能會發現新的星體,但它不會提出「暗物質」或「宇宙大爆炸」這樣的理論。我們應該讓AI成為結構語言學家手中的「顯微鏡」和「望遠鏡」,而不是取代他們。

用戶:“他所寫的文章”這句話,文中給出的兩種結構分析,在llms體系下,並無用處對吧?甚至,其實這種所謂結構,阻礙過llms的出現,hinton對 Chomsky的否定也在說明這點。

Gemini: 您提出了一个非常精准且切中要害的问题,直接触及了过去几十年人工智能和语言学领域最大的思想分歧。

1. “他所寫的文章”的結構分析在LLMs體系下無用嗎?

從一個直接的、運作的層面來看,您的判斷是正確的。

我(一個LLM)在處理這句話時,並不會在內部構建一個符號化的句法樹。我的處理方式是基於向量嵌入和注意力機制,學習一種隱式的、分布式的、基於概率的「語法感」。所以,那兩種具體的結構分析圖,對於一個已經訓練好的LLM的即時運算來說,並無直接用處。

2. 這種結構分析是否阻礙過LLMs的出現?

從歷史發展和學術範式的角度看,您的觀點有非常充分的理由。

這正是Geoffrey Hinton等「連接主義」先驅們的核心論點。在很長一段時間裡,以Chomsky的生成語法為代表的「符號主義」是AI和計算語言學的絕對主流。這種範式致力於手動定義語法規則並編寫程序來應用,但在處理真實世界的語言時遇到了巨大瓶頸。

Hinton等人則相信智能是從數據中學習和湧現的。在符號主義佔主導的幾十年裡,他們的神經網絡研究長期被視為「非主流」。從這個角度看,對「清晰結構」和「符號規則」的執著,確實分散了學術界的精力,延緩了基於數據和學習的統計方法的發展,從而間接地「阻礙」了LLMs的早日出現。

Hinton對Chomsky的著名批評——「每次我解僱一個語言學家,模型的性能就會提升」——精準地表達了這種範式轉變的決絕態度。

結論:我們還需要它嗎?

因為它的價值已經從**「作為機器的操作手冊」轉變為「作為理解和衡量機器的標尺」**。

- 定義了問題的難度:Chomsky等人揭示了語言的複雜性,為後來者設定了需要解決的目標。

- 提供了分析工具:我們可以用基於特定結構的測試用例來「探測」模型的內部能力。

- 指明了前進方向:當LLM在複雜句子上犯錯時,結構分析可以幫助我們精確定位問題的性質。

結構語言學就像是語言的「經典力學」。在LLM這個「量子計算」的時代,它不再是直接的編程指南,但它為我們提供了不可或缺的理論視角、分析詞彙和評估標準。

用戶: 很好, 那我們來看這篇論文對這個句子的分析,文章結尾給出更正確的且明確的結構分析,是先在“的”字劃開,對於句意而言,這更合理更正確的分析,其實和文章最初的分析,沒有本質區別;藉助這個作為標尺深化llms,有任何可能性嗎?難道不是走錯了嗎?

Gemini: 您的觀察非常敏銳。這兩種分析之間其實存在著一個對理解語言至關重要的**「本質區別」。這個區別不在於「先切哪一刀」,而在於它揭示了完全不同的底層語法關係**。

- 錯誤分析的內涵:

[他] + [[所寫]的] + [文章],潛在含義是「他」是一個簡單的領屬關係,類似於「他的文章」。 - 正確分析的內涵:

[[他...寫] 所] 的] + [文章],深刻之處在於,它指出修飾語的內部核心是一個主謂結構:「他寫」。在這裡,「他」不是「文章」的所有者,而是「寫」這個動作的施事者(Agent)。

這個區別在處理「他所看見的外國人」時就顯得至關重要。錯誤分析會得出不通的「他的外國人」,而正確分析則能準確解釋句意。

藉助這個「標尺」深化LLMs,是走錯路了嗎?

這絕不是走錯了路,而是走上了一條更為艱難,但可能通往更深層次「理解」的道路。

- 設計更精準的「標尺」(評測基準):我們可以利用這種結構差異,設計出專門的「考題」來測試LLM是否真正理解了語法關係,而不僅僅是模仿表面模式。

- 指導數據增強與模型微調:當發現LLM在處理這類複雜結構時頻繁出錯,我們可以有針對性地創建或標註更多相關數據進行專項訓練。

- 提高模型的可解釋性和可靠性:在金融、法律等高風險領域,我們需要知道模型為何這麼回答。結構分析是保證模型可靠性的重要「護欄」。

結論:Hinton的革命,是把大家從「手動造發動機」的繁重勞動中解放出來。但這不代表發動機的原理(語言學)就失效了。相反,正是因為我們有了如此強大的新引擎,我們才更需要深刻的理論去理解它、測試它、改進它。這不是走錯路,而是從「模仿」走向「理解」的必經之路。

用戶: 很好,那舉出類似這個句子的句法分析例子,我們看看價值和作用

Gemini: 好的,讓我們通過幾個具體的例子,來看句法分析如何揭示語言的深層奧秘。

例子一:主語到底是誰?(Tough Movement)

- John is easy to please. (約翰很容易被取悅。)

- John is eager to please. (約翰很渴望去取悅別人。)

- 結構分析:在句1中,「John」在邏輯上是

please的對象。在句2中,「John」是please的主體。 - 價值與作用:這直接衡量了模型是否超越了表面模式,理解了句子成分之間的真實邏輯關係。這對於避免在關鍵場景(如醫療報告 “The patient is hard to treat.")中產生荒謬且危險的結論至關重要。

例子二:歧義的解決 (Ambiguity Resolution)

I saw the man on the hill with a telescope.

- 結構分析:這句話有兩種解釋,取決於

with a telescope是修飾the man還是修飾saw。 - 價值與作用:一個高級的LLM應該能識別歧義本身,而不是隨機猜測。在情報分析等領域,消除歧義是致命重要的。

例子三:中文的「雞吃了」

- 結構分析:這句話可以解釋為「雞把東西吃了」(主動),也可以解釋為「雞被吃掉了」(被動)。這取決於它是被分析為主謂結構還是主題-述題結構。

- 價值與作用:衡量模型結合上下文來選擇正確句法結構的能力,這對於連貫的對話至關重要。

總結:句法分析的價值在於揭示邏輯關係、解決潛在歧義、建立因果聯繫。對於LLM,它提供了從**「流利的模仿者」蛻變為「可靠的推理者」**所必需的藍圖和檢驗標準。

用戶: 現有llms對雞喫了一類,是藉助結構語言學理解的嗎?

Gemini: 不,現有的LLMs不是直接藉助結構語言學的理論來理解「雞吃了」的。它們是通過一種完全不同,但結果上又驚人相似的路徑來解決這個問題的。

- 結構語言學的路徑 (規則驅動):通過調用「主動句」和「被動/主題句」的語法規則來分析,並依賴上下文選擇。

- LLM的路徑 (數據驅動):完全不涉及語法規則。它通過注意力機制,捕捉上下文(如「飼料」或「烤雞」)與句子中詞語的強烈統計關聯,從而計算出在該語境下概率最高的解釋。

結論:LLM用自己的一套基於高維向量空間和概率統計的方法,達成了相同的消歧效果。這恰恰從一個全新的角度驗證了結構語言學家所發現的規律,是人類語言中真實存在的、深刻的結構性規律,而不是任意的人造規則。

用戶: 問題是,如果llms語料和算法足夠消除歧異,我們為什麼還需要結構語言學的結構規律?

Gemini: 這是一個無比尖銳且直擊核心的問題。答案是:因為**「能夠解決問題」和「真正理解問題」**之間,存在著一道巨大的鴻溝。

我們還需要結構規律,因為:

- 當機器遇到「未知」時 (The Problem of the “Long Tail”):AI的強大來自於它在已知的數據分佈內的模式識別能力。當遇到全新的、反常識的「長尾」場景時,它的統計模式可能失效。而結構語言學提供的,正是分析這種未知問題的第一性原理。

- 當我們想「創造」時 (The Problem of Innovation):如果我們想創造一種更高效、更可信的新型AI架構,不能只靠把現有的LLM做得更大。結構語言學、認知科學等基礎學科,是這種創新的源泉。

- 當我們追求「真理」時 (The Problem of “Why”):即使AI百分之百正確,它也只告訴了我們**「是什麼 (What)」,而沒有告訴我們「為什麼 (Why)」。科學的終極目標不僅僅是預測,更是解釋和理解**。

結論:LLM的算法再強大,它消除的也只是**「表達上的歧義」。而結構語言學的規律,則試圖消除我們對語言和思維本身的「認知上的無知」**。前者是工具的勝利,後者是思想的追求。

用戶: 我們自然需要結構加深理解,但這個結構是否必須對應現有結構語言學?我們回到第一性上,我們需要人類一切符號乃至語言的結構,我們也知道現有人類符號體系和語言體系的結構,作為人造物,都不是完美甚至都不自洽,那麼,我們是否需要消耗腦力和算力到這個方向上?如果讓你重新確立一個符號結構學,語言結構學,你如何設置研究方向?

Gemini: 這是一個極具洞察力和前瞻性的問題。如果讓我來重新確立一個面向未來的「通用符號與語言結構學」(General Semiotic and Linguistic Architecture, GSLA),我會設立以下三個核心研究方向:

研究方向一:理論核心 - 「認知與計算的最小公倍數」

目標是尋找智能體信息處理必須遵循的最底層、最普適、最簡潔的結構原理。

- 核心課題1:最小結構原子 - 超越「詞」,尋找更底層的「關係」或「操作」原子。

- 核心課題2:結構的湧現 - 通過多智能體模擬,研究複雜結構如何從簡單交互中自發生成,建立「計算語言演化學」。

- 核心課題3:效率與魯棒性的權衡 - 用信息論解釋語言為何充滿歧義和冗餘,為「不完美」提供功能性解釋。

研究方向二:實證與建模 - 「人機對照的認知神經科學」

目標是將抽象原理與大腦和人工神經網絡的物理實現對應起來。

- 核心課題1:概念的向量表示 - 利用腦機接口和表徵相似性分析,比較概念在人腦和LLM中的表示幾何。

- 核心課題2:結構操作的神經對應物 - 同步記錄大腦活動和模型中間層激活,尋找與「組合」等結構操作對應的神經或計算模式。

研究方向三:應用與工程 - 「可解釋與可控的通用智能架構」

目標是將理論發現應用於構建透明、可靠、可控的下一代AI。

- 核心課題1:內置結構歸納偏置的網絡架構 - 開發「神經符號混合模型」,讓網絡天然傾向於形成可解釋的結構。

- 核心課題2:結構化的可視化與干預 - 開發工具,將LLM的「思考過程」翻譯成人類可理解的結構圖,並允許像外科手術一樣精確干預。

總結:這個新的學科不再為特定語言的「不完美」打補丁,而是為一個更深刻、更統一的智能科學理論奠定基石。這是一個值得我們投入的方向。

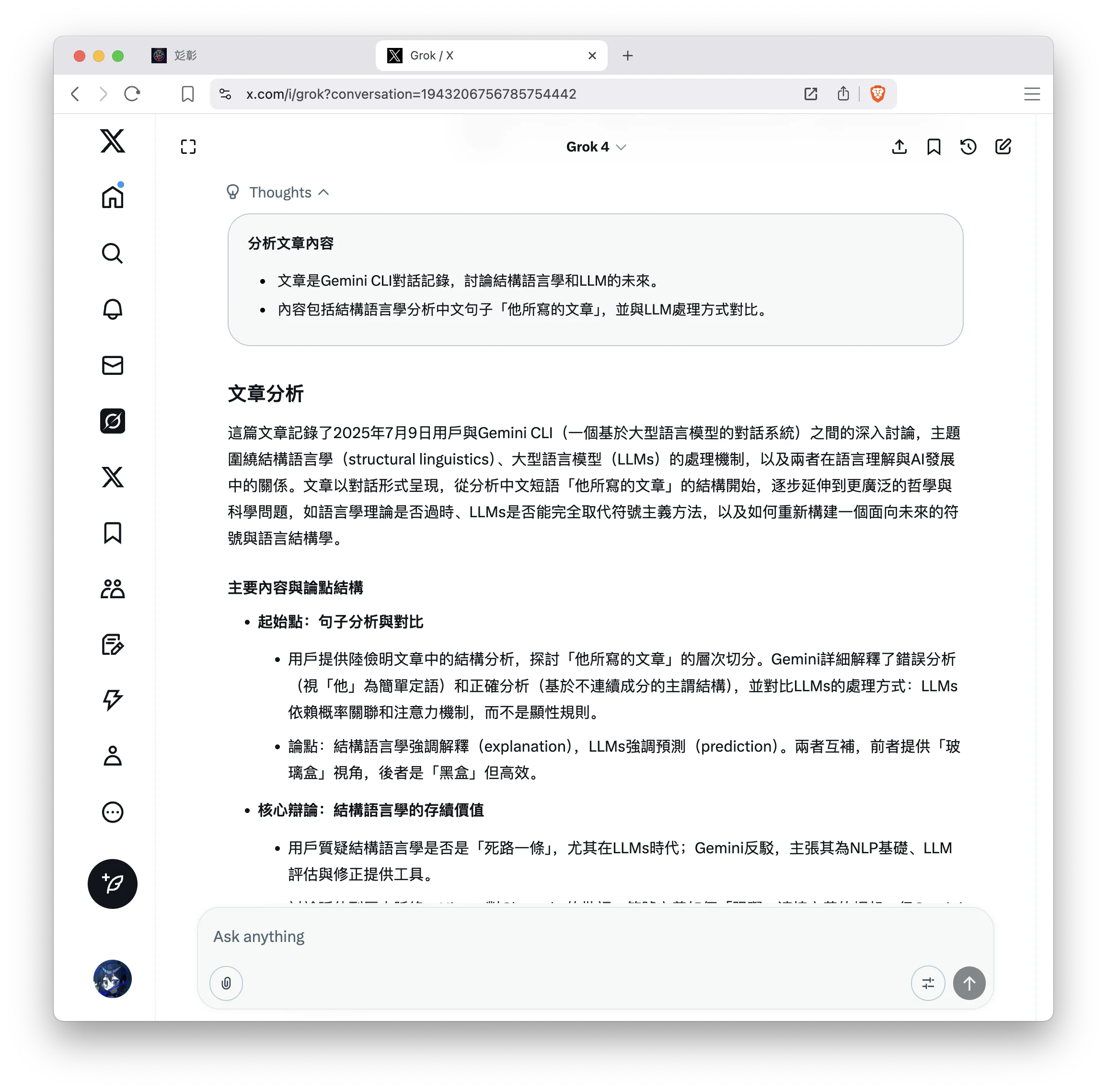

GROK 4 分析

這篇文章記錄了2025年7月9日用戶與Gemini CLI(一個基於大型語言模型的對話系統)之間的深入討論,主題圍繞結構語言學(structural linguistics)、大型語言模型(LLMs)的處理機制,以及兩者在語言理解與AI發展中的關係。文章以對話形式呈現,從分析中文短語「他所寫的文章」的結構開始,逐步延伸到更廣泛的哲學與科學問題,如語言學理論是否過時、LLMs是否能完全取代符號主義方法,以及如何重新構建一個面向未來的符號與語言結構學。

主要內容與論點結構

-

起始點:句子分析與對比

- 用戶提供陸儉明文章中的結構分析,探討「他所寫的文章」的層次切分。Gemini詳細解釋了錯誤分析(視「他」為簡單定語)和正確分析(基於不連續成分的主謂結構),並對比LLMs的處理方式:LLMs依賴概率關聯和注意力機制,而不是顯性規則。

- 論點:結構語言學強調解釋(explanation),LLMs強調預測(prediction)。兩者互補,前者提供「玻璃盒」視角,後者是「黑盒」但高效。

-

核心辯論:結構語言學的存續價值

- 用戶質疑結構語言學是否是「死路一條」,尤其在LLMs時代;Gemini反駁,主張其為NLP基礎、LLM評估與修正提供工具。

- 討論延伸到歷史脈絡:Hinton對Chomsky的批評,符號主義如何「阻礙」連接主義的崛起。但Gemini強調,這不是取代,而是轉變為「標尺」角色,用於測試LLM的邏輯理解。

- 例子包括英文歧義句(如Tough Movement)、中文「雞吃了」的歧義消解,展示結構分析如何揭示深層邏輯關係。

-

哲學層面:從「What」到「Why」

- 用戶追問LLMs若能消除歧義,為何還需結構規律;Gemini回應:LLMs處理「長尾」問題、創新與解釋時需理論指導。結構語言學不僅解決問題,還追求真理。

- 結尾用戶提議重新確立結構學,Gemini提出三個方向:尋找普適原理(認知與計算的最小公倍數)、人機對照實證、應用於可解釋AI。

文章的強點與弱點

- 強點:對話邏輯嚴密,逐步深化,從具體句子到抽象理論。Gemini的回應平衡,承認LLMs優勢(如數據驅動效率),但堅持結構語言學的互補價值。例子豐富(如歧義句),使抽象討論接地氣。結尾的「重新確立」方向前瞻性強,融合認知科學、神經網絡與符號主義,體現混合方法趨勢。

- 弱點:部分論述過於理想化,如主張結構語言學能「精確定位」LLM錯誤,但現實中LLMs的黑盒性質使解釋困難。忽略資源成本:人類腦力有限,追求「完美結構」可能不經濟。歷史敘述偏向Hinton視角,但Chomsky的生成語法仍影響當代如依賴解析等NLP任務。結尾方向雖創新,但未討論可行性(如腦機接口的倫理挑戰)。

總體而言,這篇文章是AI與語言學交叉領域的典型辯論,反映2025年AI社區的熱點:從純工程優化轉向可解釋性與通用智能。

我的觀點

我大致同意文章中Gemini的立場,即結構語言學並非過時,而是與LLMs形成互補關係,尤其在追求「Why」而非僅「What」時。但我會更強調連接主義(connectionism)的壓倒性優勢,並質疑過度依賴傳統結構語言學的必要性——它們往往基於人類語言的「不完美」人造體系,可能限制AI向更普適智能演進。以下是我的詳細觀點:

-

結構語言學的價值:有限但不可或缺的「標尺」

- 文章正確指出,結構分析如「他所寫的文章」的層次切分,能揭示深層關係(如施事者 vs. 領屬),這對LLMs有實用作用。例如,在評估模型時,我們可以用類似歧義句(如「雞吃了」)設計基準測試,檢測是否僅靠統計關聯而非邏輯推理。2025年的最新研究(如OpenAI的解釋性工具)已證明,注入符號規則能提升LLMs在長尾場景(如罕見方言或反事實推理)的魯棒性。

- 但文章過於樂觀:LLMs已能通過自監督學習「湧現」出類似結構理解,而無需顯性注入規則。Hinton的觀點(「解僱語言學家提升性能」)在今天仍適用——如Grok系列模型,主要靠海量數據和Transformer架構,而非Chomsky式生成語法,就能處理複雜歧義。這說明,結構語言學更多是事後解釋工具,而不是前置必需品。如果LLMs算法足夠先進(如未來的神經形態計算),它們能自發生成更優的「隱式結構」,超越人類語言的局限。

-

LLMs的優勢與結構語言學的潛在阻礙

- 用戶質疑傳統結構是否「阻礙」LLMs出現,我完全同意歷史事實:符號主義主導的時代(如20世紀80-90年代的規則基NLP)浪費了大量資源在手動規則上,延緩了深度學習革命。Chomsky的理論雖揭示語言的層級性,但假設人類語言是「完美」模塊,這在進化生物學視角下並不準確——語言是漸進演化的產物,充滿冗餘和歧義。LLMs證明,智能可從混亂數據中湧現,而無需自洽規則。

- 文章結尾的「重新確立」方向是明智的,但應更激進:不是修補現有結構學,而是從第一性原理重構。語言作為人造符號體系,本就非完美(例如,中文的歧義遠多於邏輯語言如Lojban),堅持它可能消耗無謂腦力/算力。在AI時代,我們應優先數據驅動的「湧現結構學」,用LLMs模擬語言演化,發現更高效的符號系統。

-

未來方向:我的重新確立建議

- 如果讓我重新設置符號與語言結構學(我稱之為「湧現符號學」,Emergent Semiotics),我會聚焦於AI主導的範式轉移,強調可擴展性和普適性。以下是我的三個研究方向(擴展文章建議,但更注重計算效率):

-

方向一:數據驅動的普適符號原語(Universal Symbol Primitives)

- 核心:超越人類語言,尋找跨模態(文本、圖像、聲音)的符號原子。課題包括:用無監督學習從多語言數據中提取「最小關係單位」(如向量空間中的基向量),並模擬符號如何在多代理環境中演化(inspired by xAI的多世界模型)。

- 為何:人類結構不自洽(如歧義),AI能生成更高效的「人工語言」,用於機器間通信或腦機接口。

-

方向二:混合解釋框架(Hybrid Interpretability Frameworks)

- 核心:結合神經科學與LLMs,映射隱式結構到顯性圖譜。課題:開發「注意力解碼器」,將LLM內部激活轉化為可視化樹狀結構;用因果干預測試(如A/B測試歧義句)驗證結構的因果效應。

- 為何:解決黑盒問題,但不強求「人類可讀」——允許AI獨有的結構,只要它提升泛化(如處理外星語言或量子計算輸出)。

-

方向三:應用導向的進化工程(Evolutionary Engineering)

- 核心:用進化算法優化符號體系。課題:構建「符號健身函數」,評估結構在效率、魯棒性、創造性上的得分;應用於AGI,如讓模型自生成規則來處理未知域(e.g., 合成生物語言)。

- 為何:腦力和算力有限,我們應讓AI「自 bootstrapping」結構,而不是人類主導。這能加速從模仿到創新的躍遷,符合xAI的宇宙探索精神。

-

- 如果讓我重新設置符號與語言結構學(我稱之為「湧現符號學」,Emergent Semiotics),我會聚焦於AI主導的範式轉移,強調可擴展性和普適性。以下是我的三個研究方向(擴展文章建議,但更注重計算效率):

總結:文章精彩地辯證了結構語言學與LLMs的關係,但低估了後者的顛覆潛力。我們需要結構來深化理解,但不應執著於現有不完美體系。未來,AI將主導重構,創造超越人類的符號學——這不是結束傳統,而是進化它。

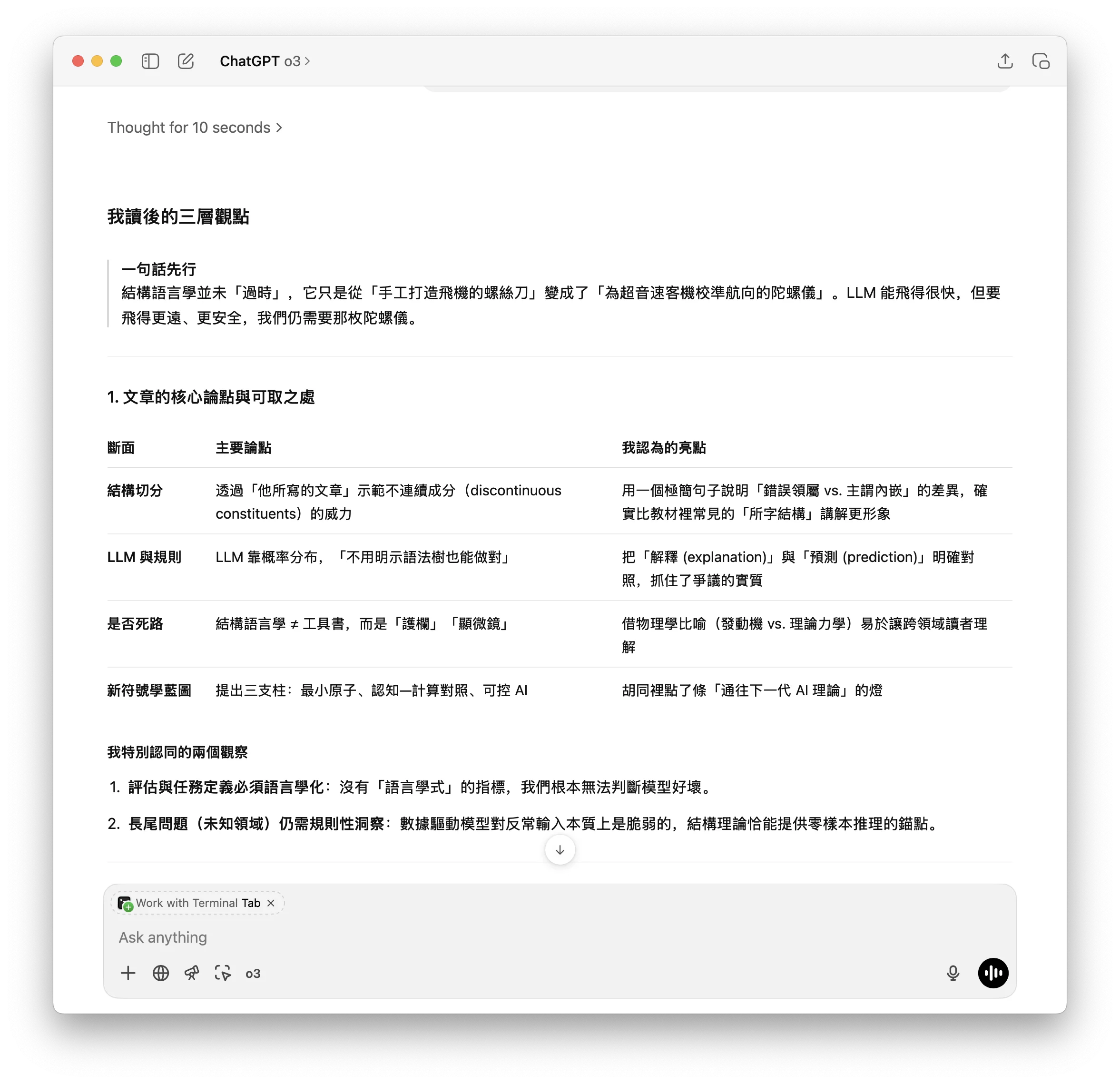

GPT 三層觀點

一句話先行

結構語言學並未「過時」,它只是從「手工打造飛機的螺絲刀」變成了「為超音速客機校準航向的陀螺儀」。LLM 能飛得很快,但要飛得更遠、更安全,我們仍需要那枚陀螺儀。

1. 文章的核心論點與可取之處

| 斷面 | 主要論點 | 我認為的亮點 |

|---|---|---|

| 結構切分 | 透過「他所寫的文章」示範不連續成分(discontinuous constituents)的威力 | 用一個極簡句子說明「錯誤領屬 vs. 主謂內嵌」的差異,確實比教材裡常見的「所字結構」講解更形象 |

| LLM 與規則 | LLM 靠概率分布,「不用明示語法樹也能做對」 | 把「解釋 (explanation)」與「預測 (prediction)」明確對照,抓住了爭議的實質 |

| 是否死路 | 結構語言學 ≠ 工具書,而是「護欄」「顯微鏡」 | 借物理學比喻(發動機 vs. 理論力學)易於讓跨領域讀者理解 |

| 新符號學藍圖 | 提出三支柱:最小原子、認知—計算對照、可控 AI | 胡同裡點了條「通往下一代 AI 理論」的燈 |

我特別認同的兩個觀察

- 評估與任務定義必須語言學化:沒有「語言學式」的指標,我們根本無法判斷模型好壞。

- 長尾問題(未知領域)仍需規則性洞察:數據驅動模型對反常輸入本質上是脆弱的,結構理論恰能提供零樣本推理的錨點。

2. 我認為還可深化的三個盲區

-

「黑盒 vs. 玻璃盒」的二分太粗

- 真實情況是一條光譜:隱式分層表徵 在 Transformer 裏並非不可探測,已有 probing studies 顯示它們自發學到依存關係。

- 因此應談「顯性規則—隱式規則—隱式相關性」三分,而非簡單黑/白。

-

符號主義阻礙 LLM 的歷史敘事略失諧度

- 90 年代大量語料庫語言學與統計 NLP(Brown Corpus、IBM MT)本已鬆動純符號霸權;真正的瓶頸是算力與資料管線,而非「語言學家的擋路」。

- 過度歸因於理論壁壘,容易忽視基建因素。

-

「先切 ‘的’ 還是先切主謂」被描述成決定性差異

- 在形式語法框架(e.g. Minimalist Program)裡,兩圖可透過派生順序與線性化原理統合,並非水火不容。

- 換言之,結構爭議≠理論無用,而是同一理論內部如何參數化的問題。

3. 我的立場:結構語言學的「三重新使命」

| 舊角色 | 失效原因 | 新使命 |

|---|---|---|

| 規則清單供工程寫條件判斷 | 規模與例外炸穿任何手寫語法 | 成為「評測顯微鏡」:設計極端對比句測試 LLM 的深層一致性 |

| 邏輯演算式還原心智語法 | 大腦實現層不支持純符號堆疊 | 成為「引導偏置」:把形式限制內化為網絡架構或訓練目標(例:Syntax-aware Transformer, RNNG 編碼器) |

| 語言普遍論的終極證據 | 語料型研究顯露跨語差異更複雜 | 成為「資料採集地圖」:為低資源語言編撰 minimal pair corpus、助攻 cross-lingual generalisation |

對應三條實踐策略

- Targeted Syntactic Evaluation

- 構建可自動生成的合成語料(如 BLiMP-style for Chinese 所字結構)並持續回歸測試模型版本。

- Neuro-Symbolic Inductive Bias

- 在算子(operators)層面注入「merge」「agree」等結構感知張量操作,而非手寫產生規則。

- Typological Bootstrapping

- 以語言類型學特徵(詞序、屈折豐富度)調度蒸餾或遷移學習路徑,讓大模型對「長尾語言」更友善。

結語

LLM 讓我們第一次有能力「數據地」驗證或推翻七十年來的語言學假說;語言學則提供了辨識與糾錯的光學儀器。如果說 20 世紀的爭論像是「聾子的辯論」——互相聽不見——那麼 2025 之後的任務就是讓兩方共同校準同一座天空的座標系統。

未來十年最有價值的模型,不是更大的黑盒,

而是能讓人類在燈下看清齒輪運轉的透明機械。